Zur Lösung der Probleme bedarf es eines KI-Spezialisten, der an der einen oder anderen Stellschraube dreht, wie z. B. (*Q38):

- Den Algorithmus verbessern über Änderung der Hyperparameter

- Mehr Merkmale finden, sprich mehr Eingangsparameter generieren

- Mehr Daten hinzuziehen

- Einen anderen Algorithmus probieren (z. B. den „k-nächste-Nachbarn-Algorithmus“)

Was sind Hyperparameter? Dies sind z. B. die Lernrate, die Anzahl der Epochen, die verwendete Aktivierungsfunktion, die Anzahl der Hidden-Layer etc..

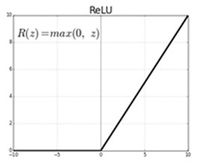

Hinweis: Die Anzahl der Epochen von 1.000 auf 10.000 zu steigern, bringt z. B. wenig Erfolg. Die Aktivierungsfunktion von Tanh auf die sehr häufig verwendete ReLU (Rectified Linear Unit, s. Abbildung 52) umzustellen, ergibt dagegen ca. 5% mehr Lernerfolg.

Abbildung 52 (*Q39): ReLU-Aktivierungsfunktion

- 72 -