Diese KI-Algorithmen werden bei Brettspielen in der Regel nicht von Menschen hinterfragt. Ein Problem entsteht aber z. B. dann, wenn die Bank einen Kredit trotz bester Bonität verweigert oder ein Onlineshop dem Kunden beharrlich Bücher vorschlägt, die man nie im Leben lesen würde (*Q1). Die Auswirkungen Maschinellen Lernens kennt jeder aus dem Alltag, aber die Algorithmen sind oft nicht transparent. Liegt der Algorithmus falsch oder ist der Betroffene wirklich nicht kreditwürdig? Je weitreichender die Einsatzgebiete solcher Algorithmen sind, umso gefährlicher sind mögliche Fehlschlüsse oder Ungenauigkeiten. Dies kann jeder sofort nachvollziehen, wenn es beispielsweise um das autonome Fahren geht (Vgl. *Q5).

Ein anderes Problem ist die Güte der Daten. Sind die Daten nicht ausgewogen, kann es z. B. sein, dass KI-Entscheidungen von Vorurteilen (unconscious bias) geprägt sind.

Überraschender Weise sieht Tesla- und SpaceX-Chef Elon Musk in der Künstlichen Intelligenz ein Risiko für den Fortbestand der menschlichen Zivilisation. Wenn intelligente Systeme in der Lage wären, sich eigene Ziele zu setzen, könnte es gefährlich werden. Man sollte schon heute die KI gesetzlich regeln und damit in die Schranken weisen (*Q6).

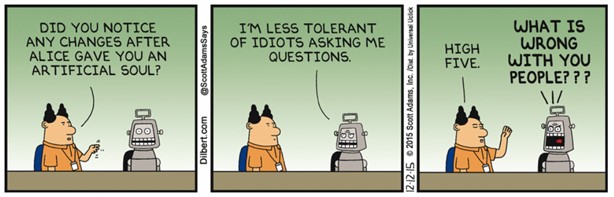

Abbildung 4 (*Q7): Künstliche Gefühle statt Künstlicher Intelligenz

Ob sie uns tatsächlich gefährlich werden können, sei dahingestellt. Aber es gibt wirklich abschreckende Beispiele, wie z. B. die sog. DeepFake-Technologie. Zum 51. Jahrestag der erfolgreichen Mondlandung (20. Juli 2020) hat ein Projekt des Massachusetts Institute of Technology (MIT) eine Rede gefälscht, die Nixon gehalten hätte, wenn Apollo 11 auf dem Weg zum Mond verloren gegangen wäre (siehe *Q8). Es will damit auf die Gefahren hinweisen, die durch gefälschte Medieninhalte entstehen können.

- 3/1 -